Vía Decrypt

En Resumen

- Investigadores de la Universidad de Stanford concluyen que los modelos de lenguaje grande (LLM) como GPT-4 y Bard no cumplen con el Acta de IA de la UE.

- El estudio revela una amplia discrepancia en el cumplimiento de los requisitos de la ley.

- Se destaca la falta de transparencia en la divulgación de datos, energía utilizada y metodología para mitigar riesgos de la IA.

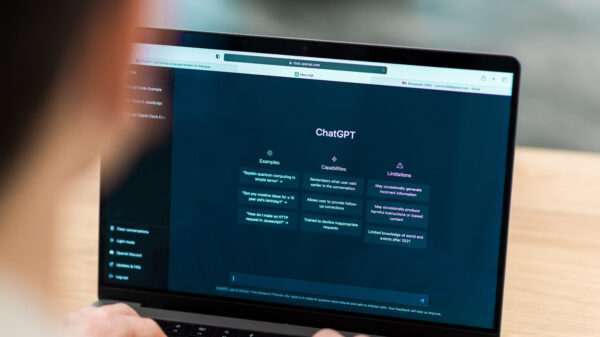

Investigadores de la Universidad de Stanford concluyeron recientemente que ningún modelo de lenguaje grande (LLM, por sus siglas en inglés) utilizado en herramientas de inteligencia artificial como el GPT-4 de OpenAI y el Bard de Google no cumplen con el Acta de Inteligencia Artificial (IA) de la Unión Europea (UE), según informó Decrypt.

El Acta, que es la primera de su tipo en regular la IA a nivel nacional y regional, fue adoptada recientemente por el Parlamento Europeo. El Acta no solo regula la IA dentro de la UE, que abarca a 450 millones de personas, sino que también sirve como un modelo pionero para las regulaciones mundiales de IA.

Sin embargo, según el último estudio de Stanford, las empresas de IA tienen un largo camino por recorrer si pretenden cumplir con la normativa.

En su investigación, los investigadores evaluaron el grado de cumplimiento de diez proveedores de modelos importantes, con los 12 requisitos descritos en el Acta de IA en una escala del 0 al 4.

El estudio reveló una amplia discrepancia en los niveles de cumplimiento, con algunos proveedores obteniendo menos del 25% para cumplir con los requisitos de la Ley de IA, y solo un proveedor, Hugging Face/BigScience, obtuvo más del 75%.

Claramente, incluso para los proveedores con puntajes altos, hay margen para una mejora significativa.

El estudio arroja luz sobre algunos puntos cruciales de incumplimiento. La falta de transparencia en la divulgación del estado de los datos de entrenamiento con derechos de autor, la energía utilizada, las emisiones producidas y la metodología para mitigar posibles riesgos fueron algunos de los hallazgos más preocupantes, escribieron los investigadores.

Además, el equipo encontró una aparente disparidad entre las versiones de modelos abiertos y cerrados, con las versiones abiertas que llevan a una divulgación más sólida de recursos pero que implican mayores desafíos para monitorear o controlar la implementación.

Stanford concluyó que todos los proveedores podrían mejorar su conducta de manera factible, independientemente de su estrategia de lanzamiento.

En los últimos meses, ha habido una reducción notable en la transparencia en los principales lanzamientos de modelos. OpenAI, por ejemplo, no hizo ninguna divulgación sobre datos y cálculos en sus informes para GPT-4, citando un panorama competitivo e implicaciones de seguridad.

Las regulaciones de la IA en Europa podrían cambiar la industria

Si bien estos hallazgos son significativos, también se ajustan a una narrativa más amplia en desarrollo. Recientemente, OpenAI ha estado haciendo lobby para influir en la postura de varios países hacia la IA. El gigante tecnológico incluso amenazó con abandonar Europa si las regulaciones eran demasiado estrictas, una amenaza que luego retiró. Tales acciones subrayan la compleja y a menudo tensa relación entre los proveedores de tecnología de IA y los organismos reguladores.

Los investigadores propusieron varias recomendaciones para mejorar la regulación de la IA. Para los políticos responsables de la UE, esto incluye asegurar que la Ley de IA responsabilice a los proveedores de modelos de base más grandes por la transparencia y la responsabilidad. También se destaca la necesidad de recursos técnicos y talento para hacer cumplir la Ley, reflejando la complejidad del ecosistema de la IA.

Según los investigadores, el principal desafío radica en la rapidez con que los proveedores de modelos pueden adaptar y evolucionar sus prácticas comerciales para cumplir con los requisitos regulatorios. Sin una fuerte presión regulatoria, observaron que muchos proveedores podrían lograr hasta 30 o 40 puntos (de un total de 48 puntos posibles) a través de cambios significativos pero plausibles.

El trabajo de los investigadores ofrece una visión perspicaz del futuro de la regulación de la IA. Argumentan que, si se promulga y se hace cumplir, la Ley de IA tendrá un impacto positivo significativo en el ecosistema, allanando el camino para una mayor transparencia y responsabilidad.

La inteligencia artificial está transformando la sociedad con sus capacidades y riesgos sin precedentes. A medida que el mundo se encuentra en el umbral de regular esta tecnología revolucionaria, está quedando cada vez más claro que la transparencia no es simplemente un complemento opcional, sino que es un pilar fundamental de la implementación responsable de la IA.